Chatbots überall

Schon seit Ende 2022 verwende ich ChatGPT, seit Mitte 2023 Copilot (naja), seit ein paar Wochen Deepseek, sowie LeChat, um auch was Europäisches dabei zu haben, und auch überhaupt alle open weight Modelle, die ich irgendwie lokal zum Laufen bringen kann (wie in diesem Beitrag beschrieben, wo ich das alles auf Proxmox mit unprivilegierten LXC Containern und einer vergleichsweise günstigen Consumer Grafikkarte gemacht habe). Kürzlich hat jedoch Google Schlagzeilen gemacht, dass deren neues Modell Gemini 2.5 Flash sehr gut sein soll. Da ich eigentlich keinen Google-Account verwende, musste ich dafür zuerst einmal einen solchen vorbereiten. Irgendwie wollte mir Google jedoch nicht Zugriff auf die Version 2.5 geben, aber die Vorgängerversion 2.0 Flash mitsamt der “Deep Research” Funktion schien gleich auf. Daher dachte ich mir, dass ich das erst einmal probieren werde.

Was soll man den “tiefen Forscher” überhaupt fragen?

Für meine kleinen Projekte hier verwende ich gerne Sprachmodelle, daher liegt es nahe, an mein schon über ein Jahr altes Projekt – Unique IDs bzw. Permalinks für meine Website – anzuknüpfen (hier, hier und hier die Umsetzung). Denn mir schwebt schon seit einiger Zeit vor, endlich eine Kommentarfunktion für meine Seite einzubauen. Das ganze passt auch relativ gut zu meiner kleinen Beitragsserie über Alternativen zu US-Techgiganten1 und meinem allgemeinen Interesse and der Heimserverei und Open Source. Ich habe mich, nach einem zumindest lehrreichen Umweg über Talkyard (hier kann man meine nicht ganz erfolgreichen Versuche nachlesen), letztendlich für NodeBB (der Beitrag dazu) als Basis für meine Kommentare entschieden.

Das Problem ist jetzt, dass es zwar ein Plugin für NodeBB gibt, mit dem man eine Kommentarfunktion bekommt, aber das funktioniert von Haus aus nur für Wordpress und Ghost-Seiten. Wie ich das jetzt ummodeln könnte, damit es auch auf einer statischen Website funktioniert ist mir im Großen und Ganzen unklar. Das sind alles Javascript und Webdevelepoment-Sachen von denen ich nicht viel Ahnung habe. Die Versuche mein Anliegen an die anfangs genannten Chatbots anzutragen, haben nicht wirklich gefruchtet. Daher habe ich den Prompt kurzerhand ein weiteres Mal recyclt (schreibt man das wirklich so? Das nächste Mal schreibe ich rezykliert) und Gemini 2.0 Flash im Tiefforschermodus befragt:

Ach ja, wenn man sich Hoffnung gemacht hat, dass Google sparsam mit den Nutzereingaben umgeht, dann sollte man sich Your privacy & Gemini durchlesen. Nachdem das dann geklärt ist, kann man sich ans Werk machen. Mein zugegeben etwas schlampiger Prompt, samt Schreibfehler, sieht so aus:

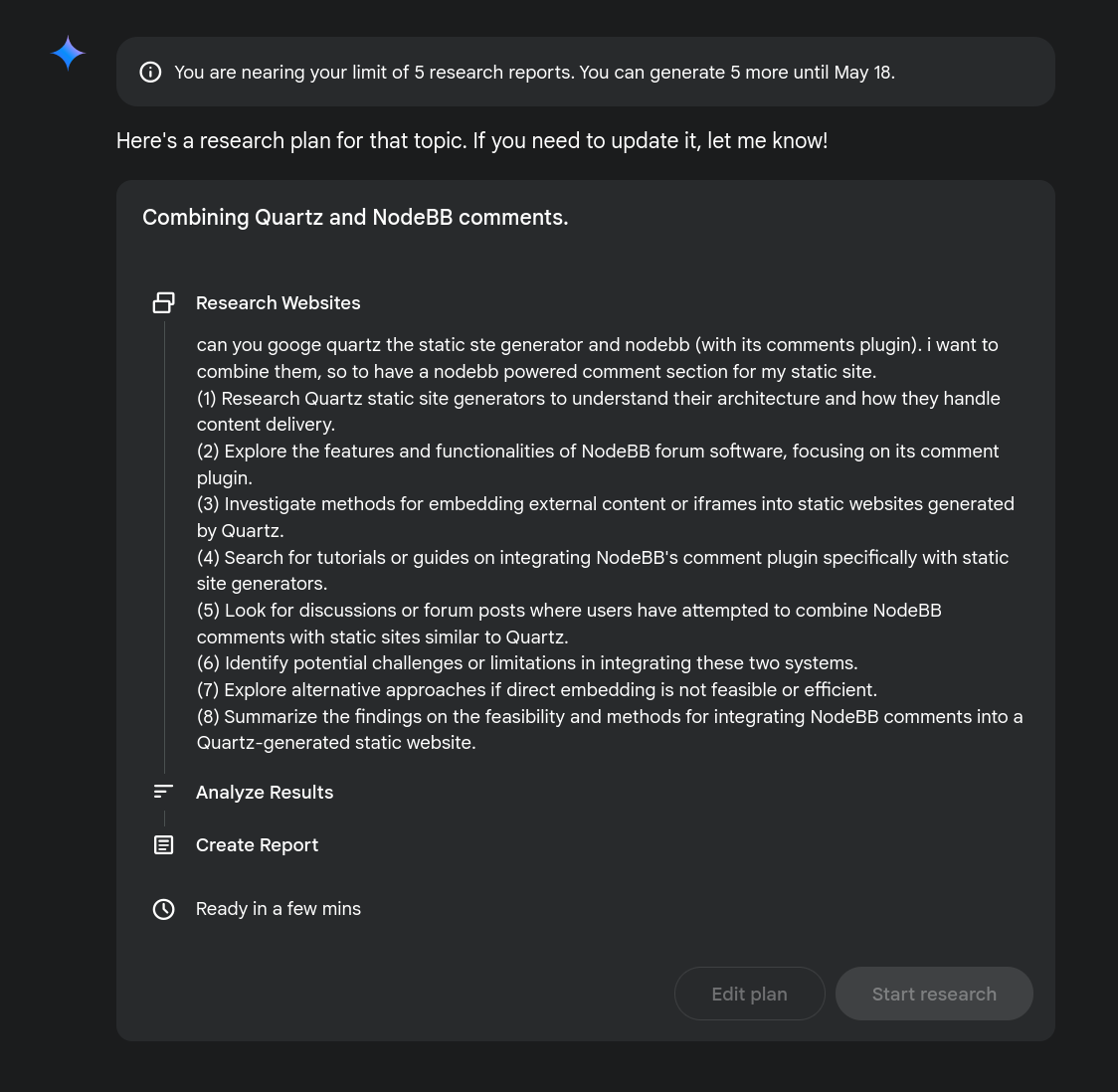

Es ist etwas redundant Google das Googlen anzuweisen, insbesondere bei diesem Modus. Hier ist die Vorgehensweise sehr strukturiert, zuerst wird man daran erinnert, dass man nur fünf solcher Suchvorgänge pro Monat hat. Dann wird der eingegebene Prompt umformuliert und man noch einmal gefragt, ob man noch Änderungswünsche hat:

Das Umformulieren finde ich sehr gut, denn damit erkennt man sofort, ob das LLM auf dem Holzweg ist, und die eigenen oft vagen und möglicherweise schlampig formulierten Angaben werden präzisiert. Wenn man dann auf “Start research” klickt, wirft der Trump erst einmal ein Schäuferl beautiful and clean coal in die Brennkammer ein und Gemini werkelt los. Und es werkelt wirklich beeindruckend, auch wenn es zuerst nicht so aussieht:

Das Ergebnis entspricht einem 18-seitigen-PDF-Dokument2 und das beinhaltet noch nicht einmal die sog. “Gedanken” oder thoughts. Das ist der Ping-Pong-Monolg des Sprachmodells, wo es immer wieder Websuchen vornimmt, das Ergebnis sich durch die Neuronen gehen lässt und gegebenfalls noch einmal eine weitere Suchanfrage startet. Diese thoughts finden sich am Ende der Ausgabe, nach den verwendeten, oder auch nicht verwendeten Quellen und lassen sich ausklappen:

Wobei untertrieben ist, dass die eine oder andere zusätzliche Suchanfrage gestartet wird. In meinem Fall sage und schreibe 17 (!) Mal eine Websuche angestoßen hat. Sich diesen Prozess zu Gemüte zu führen ist fast genauso interessant, wie das Endergebnis. Zuerst beginnt das Sprachmodell mit einer initialen Recherche…

… und weitet diese schließlich aus:

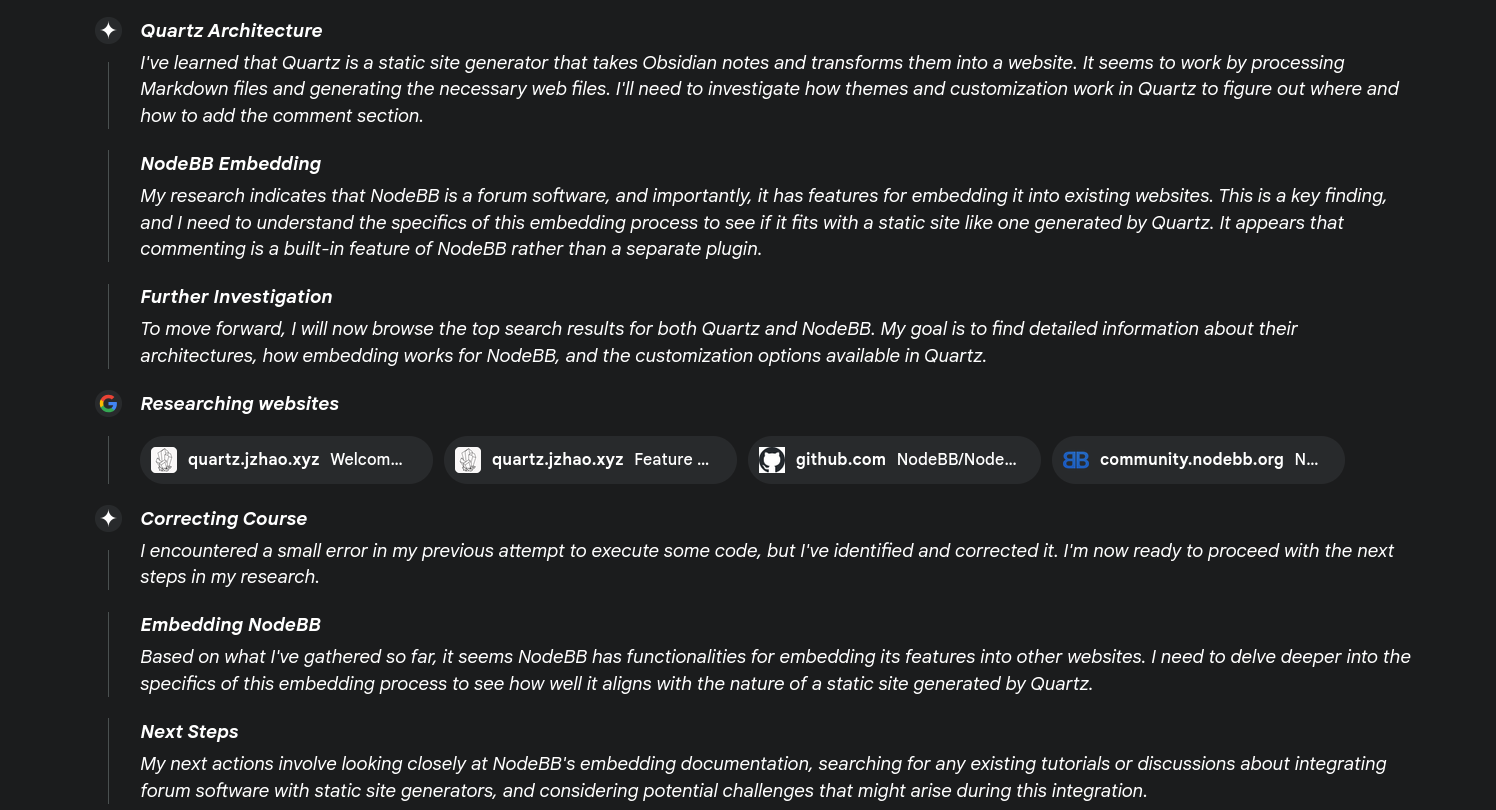

Etwas eigenartig ist hier dieser Punkt mit Correcting Course, wo es angeblich irgendeinen Code ausführen wollte (wieso?) und denn Fehler dann aber eh behoben haben will. Als nächstes sucht sich der Chatbot Infos, wie man das Unterfangen Umsetzen kann…

… sieht aber nach etwas hin und her ein, dass es keine vorgefertigen Lösungen dafür gibt (soweit war ich selbst auch schon). Dann geht das LLM die Sache allgemeiner an und sucht danach, wie grundsätzlich Kommentarfunktionen in statische Websites eingebaut werden können (soweit war ich selbst nicht und hätte es mir in Ermangelung des nötigen Fachwissens auch nicht zugetraut):

Das geht dann noch eine ganze Weile so dahin, wo auf verschiedene Aspekte eingegangen wird, wie der Suchmaschinenoptimierung (SEO)…

… oder wie NodeBB, Quartz und Javascript zusammenspielen:

Am Ende der thoughts3 wird ein Resümee gezogen und noch einmal kurz zusammengefasst:

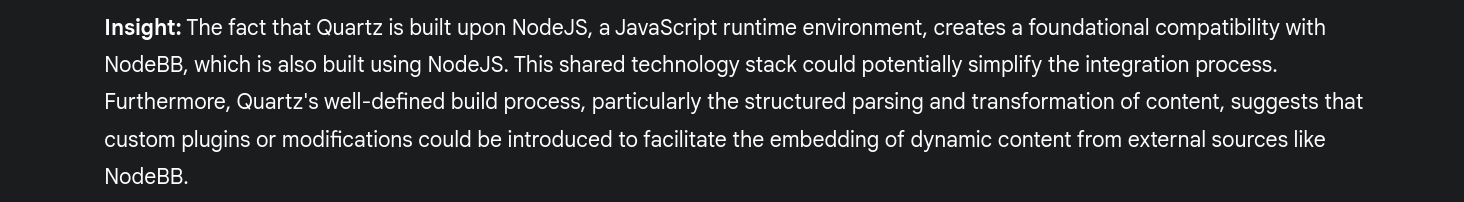

Das Ergebnis, also der “Hauptteil”, ist für einen nicht-Experten wie mich beeindruckend. Das Sprachmodell geht auf wahrscheinlich alle relevanten Schritte ein und behandelt sogar Aspekte auf die ich selbst gar nicht gekommen wäre. Bemerkenswert sind die wiederkehrenden insights…

… die das Allgemeine (Kommentarfunktion in eine statische Website integrieren) mit dem Konkreten (wie Quartz und NodeBB beide NodeJS als Basis verwenden) in Bezug bringen und ein viel größeres Lernpotential für den Nutzer hat. Anders gesagt Information wird so gesammelt, verknüpft und präsentiert, dass sich sofort ein Aha-Effekt einstellt, zumindest für relative Laien (einem Javascript-Meister wird das nicht vorm beautiful and clean Kohle-Ofen hervorholen).

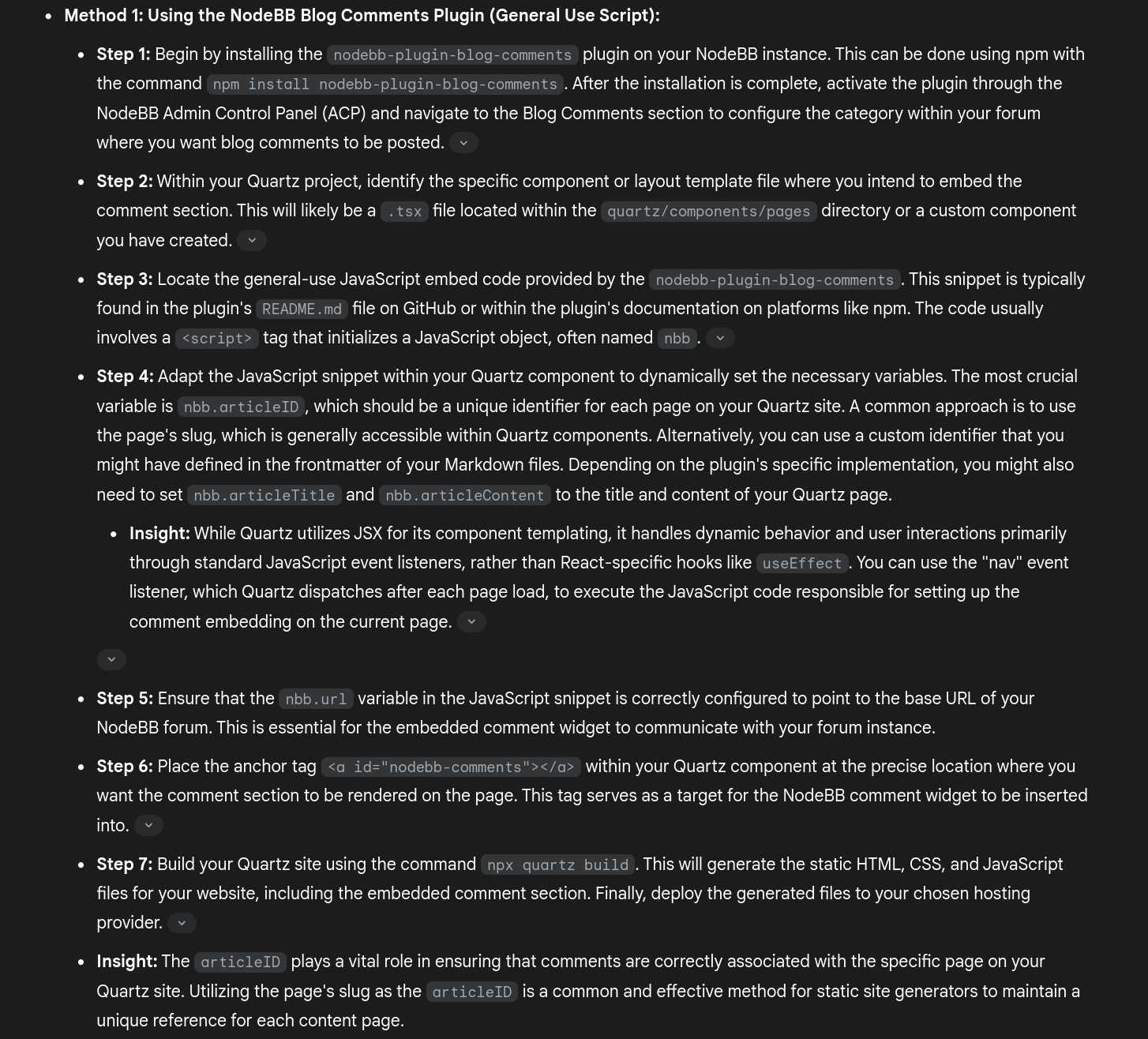

Für die Sache (Kommentarfunktion!) relevanter sind die vorgeschlagenen Lösungen, ich werde es wohl mit der Methode Nummero eins versuchen:

Aber das werde ich in einem anderen Beitrag dann auch umsetzen. Aber das soll vorerst einmal zu deep research von Gemini 2.0 flash genügen. Bin gespannt, was der jüngst veröffentlichte Nachfolger 2.5 so zusammenbringen kann. Ich kann allen Interessierten empfehlen, das unten angehängte PDF durchzulesen. Es liest sich wirklich wie ein schön recherchierter Report zu einem kleinen Softwareprojekt. Früher – also vor gut einem Dreivierteljahr – musste man noch manuell Ping-Pong Spielen mit dem Sprachmodell, um nur in die Nähe dieses Ergebnisses zu kommen. Und ich wäre überhaupt nicht so weit gekommen, da ich mich in diesem Bereich nicht gut auskenne und es für mich auch kein primäres Interesse darstellt, sondern ein Mittel zum Zweck.

Fazit

Also ich muss sagen, dass mich Gemini mit dieser aufgemotzten Recherchefunktion schwer beeindruckt hat. Alleine dem Sprachmodell beim “Denken” zuzusehen und dann innerhalb kürzester Zeit eine so umfangreiche und detaillierte Analyse eines Softwarevorhabens zu bekommen lässt einem doch nachdenklich werden. Einerseits ist es eine coole Sache per Knopfdruck und mit kurzer Anweisung solch eine Fülle an Informationen in einer verständlichen Art und Weise aufbereitet zu bekommen, andererseits macht es doch etwas nachdenklich, dass Maschinen zu so etwas fähig sind. Ja, es sind nur Werkzeuge, aber wir leben doch in einer Zeit, wo man sich nicht mehr der Illusion hingeben kann, dass sich ohne Zutun irgendwie alles einrenkt. Außerdem darf man nicht vergessen, dass diese Modelle durch das postmoderne Raubrittertum skrupelloser Konzerne erschaffen wurden. Das Internet wurde wild abgegrast und die Lage wird immer schlimmer. Ich bleibe also zwiegespalten, freue mich einerseits, dass ich à la Star Trek mit dem Computer interagieren kann, befürchte jedoch, dass wir Menschen als ziemliche Trotteln immer mehr Wege finden diese Werkzeuge für dystopischen Schabernak zu verwenden.

Footnotes

-

Mir ist die Ironie durchaus bewusst, dass ich mich im Zuge dieses Unterfangens jetzt erst recht wieder an Dr. Krakus gewendet habe, aber erstens möchte ich einen Überblick über die aktuell besten Sprachmodelle haben und ich führe die Ergebnisse dieser Recherche und womöglich auch die Ergebnisse meines Projekterls wieder der Öffentlichkeit zu. Insofern kann ich damit leben. ↩

-

For your convenience hier das ganze PDF des ersten Suchvorgangs: ↩

-

Leider kann man die Gedankengänge nicht so einfach exportieren, wie das restliche Ergebnis. Die Exportfunktion lässt dies leider einfach aus und mit copy & paste bekommt man ausschließlich einen unformatierten Haufen Text und Links vom ersten “Ping”. Alle knapp zwanzig Schritte manuell rauszukopieren ist mir zu zeitaufwändig. ↩